Conteúdo Atualizado em 4 de setembro de 2025 por felipecferreira, enjoy!

A Meta AI chamou atenção da nossa comunidade com o desenvolvimento do novo modelo de Inteligência Artificial Brain2Qwerty.

O modelo é capaz de transformar pensamentos em texto de forma não invasiva, abrindo novas possibilidades para pacientes com dificuldades de fala e mobilidade reduzida.

Utilizando IA e neurociência, essa abordagem pode redefinir a interação humano-computador.

Ao final deste conteúdo você pode acessar o paper na íntegra, desenvolvido pela equipe de pesquisa responsável (Jarod Lévy et al, 2025).

Maaas antes, preciso fazer uma “nota técnica”, fique a vontade para pular:

O Brain2Qwerty é descrito no artigo como um “modelo” que utiliza uma arquitetura de aprendizado profundo composta por módulos convolucionais e Transformers, além de um modelo de linguagem baseado em n-gramas (modelo estatístico baseado na frequência de sequências de caracteres).

Embora possua componentes semelhantes aos encontrados em Modelos de Linguagem de Grande Porte (LLMs), como o uso de Transformers para processamento de sequências, o Brain2Qwerty não se enquadra na definição típica de um LLM.

LLMs são treinados em grandes volumes de dados textuais para gerar ou compreender linguagem natural de forma geral, enquanto o Brain2Qwerty é especificamente projetado para decodificar sinais cerebrais associados à digitação, traduzindo atividade neural em texto.

Portanto, embora compartilhe algumas técnicas com LLMs, o Brain2Qwerty é mais apropriadamente categorizado como um modelo de decodificação neural especializado.

Esta foi a minha compreensão pelo contexto.. 😀

Meta AI e Brain2Qwerty: A Nova Era da Comunicação Cerebral

A Meta AI tem investido em pesquisas avançadas para desenvolver tecnologias de decodificação cerebral que sejam seguras e eficazes.

O Brain2Qwerty se destaca por usar sinais cerebrais captados por magnetoencefalografia (MEG) e eletroencefalografia (EEG) para converter pensamentos em texto.

Com um modelo de aprendizado profundo, esse sistema alcança uma taxa de erro por caractere (CER) de apenas 32% ao usar magnetoencefalografia (MEG), chegando a 19% nos melhores cenários.

Como a Tecnologia Consegue Traduzir Pensamentos em Texto

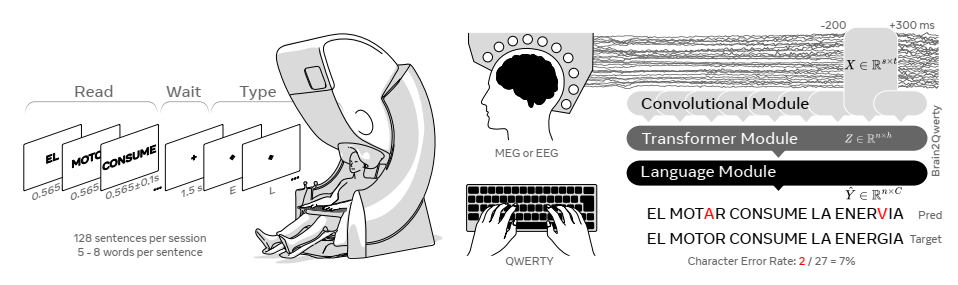

O funcionamento do Brain2Qwerty se baseia em três módulos essenciais:

Módulo Convolucional: Responsável por extrair padrões dos sinais cerebrais.

Módulo Transformer: Reprocessa as informações para refinar as previsões.

Modelo de Linguagem: Utiliza um modelo de n-gramas para melhorar a coerência do texto gerado.

Esses elementos combinados tornam possível decodificar a intencionalidade do usuário de forma mais precisa, mesmo sem implantes cerebrais invasivos.

O Funcionamento do Brain2Qwerty

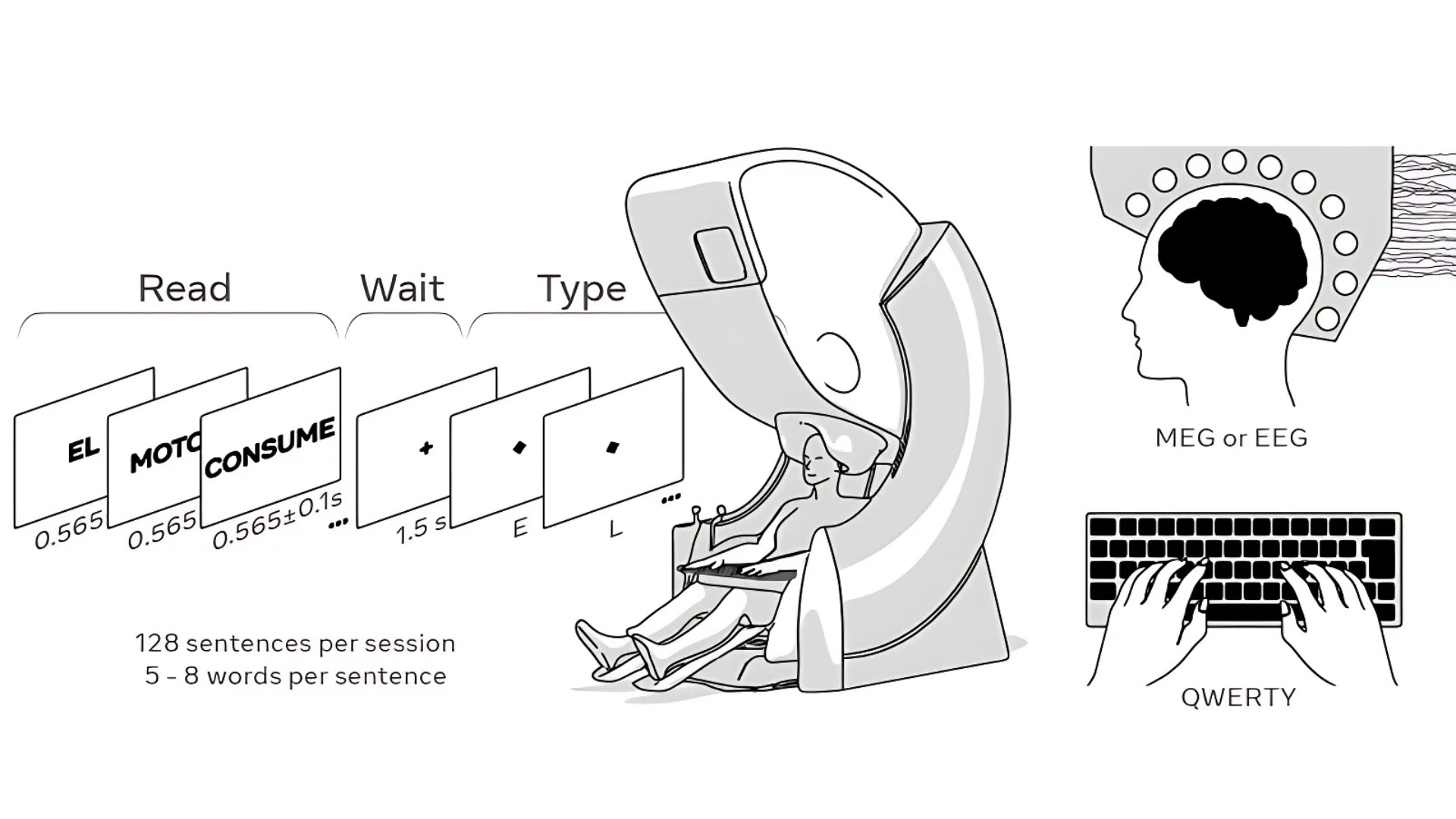

A imagem ilustra o processo de funcionamento do Brain2Qwerty, desde a leitura até a conversão do pensamento em texto:

Os participantes leem frases exibidas palavra por palavra em uma tela (Read), esperam um curto intervalo (Wait) e, em seguida, digitam o que memorizaram (Type).

Enquanto isso, sua atividade cerebral é registrada usando Magnetoencefalografia (MEG) ou Eletroencefalografia (EEG).

O sistema analisa essas ondas cerebrais e, com a ajuda de um modelo de inteligência artificial, decodifica os sinais neurais, convertendo-os em texto que é digitado em um teclado QWERTY.

Hierarquia Neural e a Transformação de Pensamentos em Comunicação

Os avanços do Brain2Qwerty também revelaram novos conhecimentos sobre a hierarquia neural envolvida na conversão de pensamentos em comunicação.

O estudo mostrou que diferentes níveis de processamento cerebral são ativados de forma sequencial ao longo da produção da linguagem: primeiro, a formação de frases (phrase level), seguida pela estruturação de palavras (word level), depois a segmentação em sílabas (syllable level) e, finalmente, a representação de letras individuais (letter level).

Essa organização hierárquica desempenha um papel essencial para transformar intenções comunicativas em comandos motores.

Durante o experimento, como eu já mencionei, os participantes tinham que reter mentalmente frases antes de digitá-las, e a atividade cerebral registrada indicou uma coordenação precisa entre as áreas responsáveis pela formulação linguística e os centros motores.

A interface conseguiu mapear como o cérebro processa cada nível linguístico e, posteriormente, envia sinais motores para que os participantes pressionassem as teclas correspondentes no teclado QWERTY.

Esses achados reforçam a complexidade e eficiência dos circuitos neurais envolvidos na comunicação humana, fornecendo direções valiosas para aprimorar futuras interfaces cérebro-computador.

Impacto e Futuro das Interfaces Cérebro-Computador

As interfaces cérebro-computador (BCI) estão evoluindo rápido (inclusive com outras tecnologias propostas pela Neuralink), e o Brain2Qwerty é um grande passo para tornar essas tecnologias mais acessíveis.

Embora desafios como a necessidade de operação em tempo real e portabilidade dos equipamentos MEG ainda existam, soluções inovadoras estão sendo exploradas e com certeza teremos mais notícias em breve.

Com avanços na miniaturização de sensores e aperfeiçoamento de algoritmos de IA, o futuro aponta para interfaces cada vez mais precisas e acessíveis.

Conclusões

O Brain2Qwerty representa um avanço significativo na busca por comunicação assistida sem necessidade de procedimentos invasivos.

Seu impacto potencial na vida de pessoas com limitações motoras é imenso, oferecendo uma alternativa segura e eficaz para interação digital.

Com o progresso das pesquisas, esse tipo de tecnologia pode se tornar um padrão na assistência à comunicação humana e até mesmo no desenvolvimento de outras soluções..

Gostou deste conteúdo?

Quer se aprofundar ainda mais no universo da Inteligência Artificial e suas aplicações no marketing e aquisição de clientes?

É só clicar em algum lugar aqui da tela, tem um botão do WhatsApp e eu falo com você.