Conteúdo Atualizado em 25 de janeiro de 2025 por felipecferreira, enjoy!

Bora falar da DeepSeek com o modelo R1 que está disponível gratuitamente pra você experimentar?

Isso mesmo, ele tem um nível similar de complexidade e qualidade de um dos melhores modelos da OpenAI, o famoso “o1”, e você nem precisa pagar 20 ou 200 dólares..

Não sei se você percebeu mas..

O mercado de Inteligência Artificial está fervilhando!

Do jeito que a gente gosta.. ;p

A DeepSeek, um laboratório de IA de Hangzhou, na China, está dando o que falar com o lançamento do DeepSeek-R1, uma família de modelos de linguagem que promete movimentar o mercado!

Mas o que torna o DeepSeek-R1 tão especial?

Bom, a priori, o que mais impressionou os membros da comunidade internacional de AI, além da excelente performance em benchmarkings é que o modelo é open-souce!

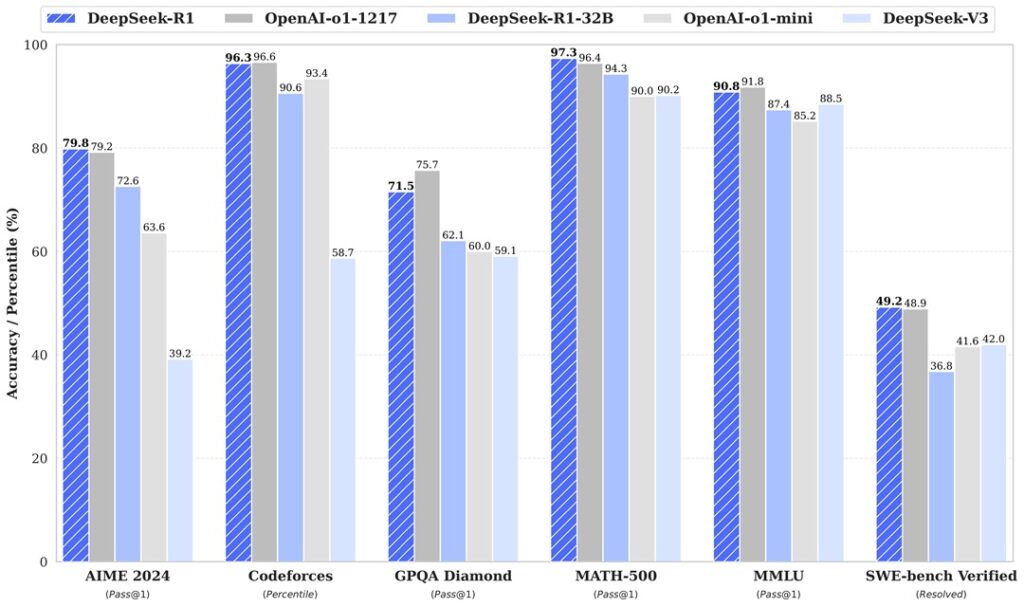

Observando o gráfico, fica claro que há variações de desempenho entre as diferentes versões do DeepSeek (R1, R1-32B e V3) e os modelos OpenAI-o1 (1217 e mini) conforme a tarefa muda.

Em certos cenários, como no AIME 2024, o DeepSeek-R1 se destaca ao atingir índices de aproximadamente 79,8% de acurácia, ligeiramente superior ao OpenAI-o1-1217, que obteve 79,2%.

AIME (American Invitational Mathematics Examination): Um exame de alto nível em matemática que avalia habilidades avançadas de resolução de problemas.

Já no Codeforces, o OpenAI-o1-1217 mostra leve vantagem (96,6%) frente ao DeepSeek-R1 (96,3%), enquanto o DeepSeek-R1-32B e demais modelos ficam alguns pontos atrás.

Codeforces: plataforma amplamente usada por programadores para resolver problemas de algoritmos e estruturas de dados. Codeforces avaliam a eficiência da IA em compreender e resolver problemas.

Em tarefas voltadas à resolução matemática, como MATH-500, o DeepSeek-R1 retoma a liderança com cerca de 97,3%, sinalizando que a engenharia do modelo pode favorecer habilidades de raciocínio lógico.

MATH-500: Um conjunto de problemas matemáticos avançados, projetado para testar a capacidade da IA em resolver cálculos e equações em diferentes níveis de dificuldade

Em outros testes, como o GPQA Diamond, o OpenAI-o1-1217 assume vantagem com 75,7%, sugerindo robustez em compreensão e raciocínio mais contextual.

GPQA (General Purpose Question Answering): Um teste que mede a capacidade de modelos de IA em responder a perguntas complexas e variadas, com base em múltiplas fontes de conhecimento.

Na avaliação MMLU, o OpenAI-o1-1217 atinge o pico (91,8%), embora o DeepSeek-R1 (90,8%) e o DeepSeek-V3 (88,5%) não fiquem muito atrás.

MMLU (Massive Multitask Language Understanding): Um benchmark abrangente projetado para avaliar a capacidade dos modelos de IA em compreender e responder questões de mais de 50 disciplinas, incluindo ciências, matemática, história e literatura.

Por fim, no SWE-bench, o DeepSeek-R1 (49,2%) supera levemente o OpenAI-o1-1217 (48,9%), mas ambos estão próximos.

SWE-bench (Software Engineering Benchmark): Um benchmark que avalia a capacidade da IA em realizar tarefas relacionadas à engenharia de software, como análise e geração de código, correção de bugs e documentação técnica.

Esses dados reforçam como o desempenho de cada modelo depende significativamente das características de cada tarefa.

Enquanto o DeepSeek exibe um design transparente e competitivo em cenários de lógica e problemas matemáticos, o OpenAI-o1 demonstra equilíbrio em tarefas de compreensão mais geral.

Isso abre espaço para discussões sobre a importância de modelos híbridos, uso de arquiteturas complementares e a busca por versatilidade em benchmarks mais amplos.

Vamos entender agora um pouco mais sobre o funcionamento desde modelo DeepSeek-R1!

DeepSeek-R1

O DeepSeek-R1 funciona decompondo as instruções em etapas, o que permite que ele processe informações complexas de forma mais eficiente.

Essa capacidade de “pensar” de forma estruturada é crucial para resolver problemas desafiadores, como os encontrados em áreas como matemática avançada, programação e planejamento estratégico de diferentes fluxos de dados ou operacionais.

Se você precisar saber mais sobre alguns termos técnicos como Tokens, APIs, Redes Neurais, LLMs é só interagir com os links..

Nosso dicionário está em constante expansão..

Voltando ao DeepSeek-R1, o modelo utiliza uma técnica conhecida como “test-time compute”, que permite que ele utilize mais poder computacional para gerar respostas mais profundas.

Em termos práticos, isso significa que o DeepSeek-R1 pode “pensar” por mais tempo para chegar a uma resposta mais precisa e completa.

E os resultados são impressionantes!

Como você acabou de ver, o modelo de código aberto, competindo fortemente com um outro modelo (o1) de ponta de uma das líderes no mercado mundial e com acesso pago.

Como acessar o DeepSeek-R1?

Você pode simplesmente ir pro modelo de chat, clicando aqui.

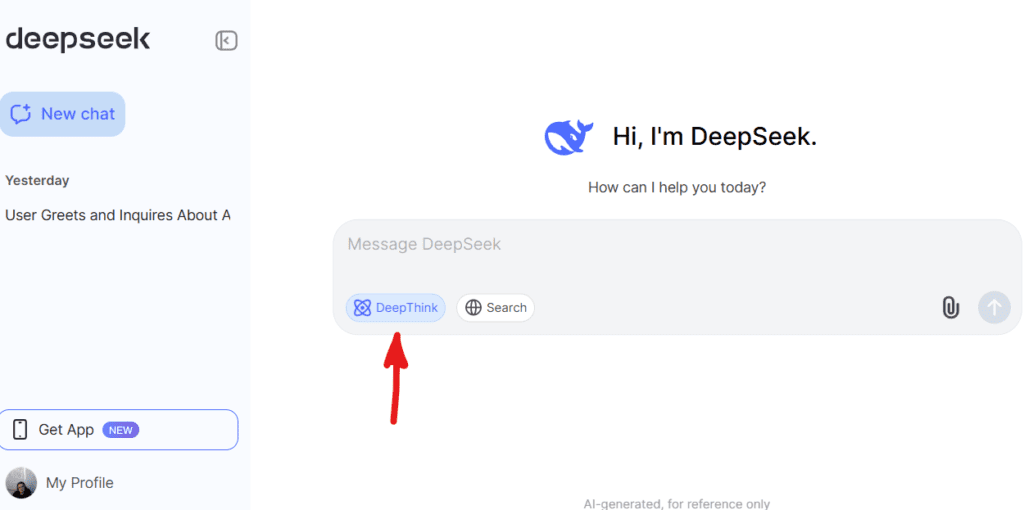

Você verá uma tela parecida com essa aqui abaixo..

O chat em si, utiliza o modelo “V3”, e ao acionar o DeepThink você habilita a utilização do “R1”.

Não encontrei na documentação limites claros de requisições (inserção de prompts, perguntas), mas o importante é que você pode testar e inclusive, comparar tarefas que já está acostumado a trabalhar com outros modelos como o Sonnet (Anthropic), Gemini (Google), e o nosso amigo o1 (OpenAI), entre tantos outros..

Quer saber mais sobre IA e como ela pode impulsionar o seu negócio?

Junte-se à nossa comunidade de especialistas em IA voltada para marketing e aquisição de clientes online!

Descubra as últimas tendências e estratégias para utilizar a IA a seu favor.

É só clicar em algum lugar aqui da tela, tem um botão do WhatsApp e eu falo com você.