Conteúdo Atualizado em 25 de janeiro de 2025 por felipecferreira, enjoy!

A inteligência artificial está em constante evolução e a busca por modelos de linguagem LLMs mais eficientes e adaptáveis é incessante.

Um novo estudo da Sakana AI, desenvolvido por Qi Sun et al (2025), intitulado “Transformer2: Self-Adaptive LLMs“, apresenta uma solução inovadora que promete revolucionar a forma como interagimos com a IA.

Basicamente o Transformer2 é um framework de autoadaptação para LLMs (Large Language Models), e permite que os modelos se ajustem a diferentes tarefas e contextos em tempo real, sem a necessidade de ajustes manuais complexos e demorados.

O que é incrível..

Bom, vamos entender um pouco melhor!

Por que isso é relevante?

Atualmente, os LLMs são geralmente otimizados para uma ampla gama de tarefas em uma única e extensa sessão de treinamento.

Esse método, conhecido como “fine-tuning”, embora eficaz, é computacionalmente intensivo e muitas vezes leva a trade-offs de desempenho.

NOTA: Trade-offs são escolhas entre dois aspectos que não podem ser maximizados ao mesmo tempo, ou seja, ganhar algo em um lado significa perder em outro.

No contexto de modelos de IA, isso acontece quando melhorar o desempenho em uma tarefa específica pode piorar em outra ou aumentar o custo computacional.

Por exemplo, ao ajustar um modelo (fine-tuning) para ser muito bom em responder perguntas matemáticas, ele pode se tornar menos eficiente para tarefas de linguagem geral.

(FIM DE NOTA)

Imagine ter que retreinar um modelo inteiro cada vez que ele precisa lidar com uma nova tarefa!

O Transformer2 elimina essa necessidade, tornando os LLMs mais ágeis e versáteis. 🤯

Como o Transformer2 funciona?

A chave para o Transformer2 está na sua capacidade de ajustar seletivamente apenas os componentes singulares das matrizes de peso dos LLMs.

Para entender isso, vamos desmistificar alguns termos:

Matrizes de Peso: As redes neurais, que compõem os LLMs, utilizam matrizes de peso para processar informações e gerar respostas. Essas matrizes são como “mapas” que orientam o fluxo de dados dentro da rede.

Componentes Singulares: Através da Decomposição em Valores Singulares (SVD), as matrizes de peso podem ser decompostas em componentes singulares, que representam as direções de maior variância nos dados.

“Expert” Vectors: O Transformer2 utiliza “expert vectors”, treinados por meio de Reinforcement Learning (RL), para modificar dinamicamente os componentes singulares e adaptar o modelo a novas tarefas. Pense neles como “especialistas” que entram em ação quando o modelo precisa lidar com um tipo específico de problema.

Lado Esquerdo

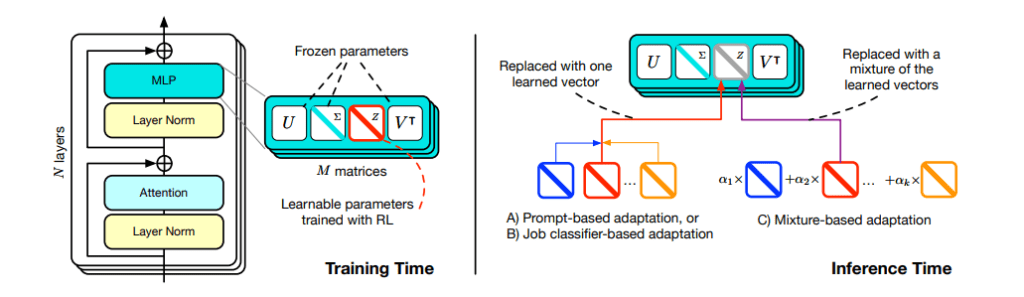

Tempo de Treinamento: No processo de treinamento, o modelo utiliza uma técnica chamada “Singular Value Fine-tuning” (SVF), que se baseia na decomposição dos pesos das camadas do modelo em componentes individuais: U, Σ, V e um vetor ajustável Z.

Parâmetros Congelados: As matrizes U e V representam informações pré-treinadas que permanecem inalteradas. Isso evita a necessidade de modificar milhões de parâmetros do modelo.

Vetores Especialistas (Z): Apenas os vetores Z, que ajustam a magnitude das singularidades, são otimizados durante o treinamento. Esses vetores são treinados para tarefas específicas, como resolução de problemas matemáticos ou compreensão de código, usando Reinforcement Learning (RL).

Eficiência: Essa abordagem reduz drasticamente o número de parâmetros a serem treinados, tornando o processo mais rápido e eficiente em termos computacionais.

Lado Direito

Tempo de Inferência: Durante a inferência (uso do modelo), são aplicadas diferentes estratégias de adaptação com base nos vetores especialistas treinados.

Isso torna o modelo flexível e ajustável em tempo real para diferentes tipos de tarefas:

Adaptação baseada em prompts: O modelo pode selecionar um vetor especialista com base no contexto ou na descrição da tarefa fornecida no prompt. Por exemplo, ao receber uma questão matemática, ele seleciona o vetor especialista relacionado à matemática.

Adaptação baseada em classificadores: Aqui, um sistema de classificação identifica a natureza da tarefa (como “matemática”, “código” ou “outras”) e seleciona automaticamente o vetor especialista apropriado.

Adaptação por mistura de vetores: Em cenários mais complexos, o modelo combina vários vetores especialistas, atribuindo pesos diferentes a cada um deles. Isso permite resolver tarefas que exigem múltiplas habilidades simultaneamente.

Resultados e Implicações do Transformer2

O estudo demonstra que o Transformer2 supera métodos populares como o LoRA (Low-Rank Adaptation) em termos de eficiência e desempenho.

O framework também se mostra versátil em diferentes arquiteturas e modalidades de LLMs, incluindo tarefas de visão-linguagem.

Tradicionalmente, modelos de linguagem eram treinados para serem “generalistas”, o que muitas vezes resultava em desempenho inferior em tarefas específicas.

Com essa abordagem de adaptação dinâmica o modelo utiliza apenas os recursos necessários para cada tarefa, economizando tempo e energia.

Ele pode adaptar seu comportamento em tempo real sem a necessidade de re-treinamento completo, tornando-se mais flexível e escalável.

Conclusão: Um Futuro Adaptativo para a IA?

O Transformer2 representa um salto significativo na busca por sistemas de IA verdadeiramente dinâmicos e auto-organizáveis.

A capacidade de se adaptar em tempo real a novas tarefas abre um leque de possibilidades para aplicações práticas em diversas áreas.

Imagine chatbots que podem aprender novas habilidades durante uma conversa, sistemas de tradução que se adaptam a diferentes dialetos e sotaques, ou assistentes virtuais que podem realizar tarefas complexas com base em instruções em linguagem natural.

Isso é simplesmente sensacional..

O futuro da IA é adaptativo e o Transformer2 está liderando o caminho.

Vamos acompanhar os próximos episódios.. aliás..

Junte-se à nossa comunidade de IA voltada para marketing e aquisição de clientes pela internet!

Compartilhe suas ideias, aprenda com especialistas e explore as últimas tendências em IA.

Nossa comunidade também lida com temas relacionados a tráfego, tracking e comunicação.

Se fizer sentido pra você, use o botão do WhatsApp em algum lugar da tela para falar diretamente comigo.

Fazendo a devida referência, você pode acessar o conteúdo completo do artigo clicando aqui.