Conteúdo Atualizado em 25 de janeiro de 2025 por felipecferreira, enjoy!

A Groq, uma promissora startup de chips de inteligência artificial (IA) do Vale do Silício, anunciou recentemente a captação de $640 milhões de dólares (algo em torno de 3.5 bilhões de reais) em uma rodada de financiamento (Série D), liderada pela BlackRock Private Equity Partners.

Com esta injeção gigantesca de capital, a avaliação da Groq agora atinge $2.8 bilhões.

Esta movimentação estratégica posiciona a empresa como uma forte concorrente contra gigantes do setor, como a Nvidia.

Nesta matéria, vamos explorar juntos os detalhes deste financiamento, os planos de expansão da Groq, e o impacto esperado no mercado de IA.

Não sabe o que é Inteligência Artificial? Clique Aqui.

Há, nessa matéria também vamos ter um pouco sobre a história desta empresa e fundadores, assim como características técnicas que diferenciam esta empresa da atual líder do mercado, a Nvidia de Jensen Huang.

Sobre a Rodada de Financiamento da Groq

A rodada de financiamento ($640 milhões de dólares), foi liderada pela BlackRock Private Equity Partners, com participação de investidores estratégicos como Neuberger Berman, Type One Ventures, Cisco Investments, Global Brain’s KDDI Open Innovation Fund III, e Samsung Catalyst Fund.

Este novo financiamento mais que dobrou a avaliação da Groq desde abril de 2021, quando a empresa havia levantado $300 milhões.

A Groq planeja usar esses fundos para aumentar significativamente sua capacidade de produção, focando na fabricação de suas unidades de processamento de linguagem (Language Processing Units – LPUs), que são projetadas para executar modelos generativos de IA com maior velocidade e eficiência energética.

Este investimento permitirá à Groq implantar mais de 100.000 LPUs no GroqCloud até o final do primeiro trimestre de 2025.

Expansão do GroqCloud: O Futuro da Inferência de IA

Com o financiamento recém-adquirido, a Groq pretende expandir seu GroqCloud, uma plataforma que já atraiu mais de 360.000 desenvolvedores para criar aplicações de IA.

O GroqCloud oferece soluções de inferência rápidas e acessíveis, permitindo que desenvolvedores de todas as partes do mundo acessem tecnologias de IA avançadas sem as restrições de custo típicas dos grandes players do setor.

Jonathan Ross, CEO e fundador da Groq, enfatizou a importância desta expansão ao declarar que “o treinamento de modelos de IA está resolvido, agora é hora de implantar esses modelos para que o mundo possa usá-los.”

Ross também mencionou planos de expansão significativa da equipe, aproveitando o financiamento para aumentar a densidade (retenção) de talentos profissionais e suportar a crescente demanda por suas soluções de inferência.

Competição Acirrada: Groq Desafia a Liderança da Nvidia

A Groq não está apenas expandindo suas operações, mas também está se posicionando como um forte concorrente da Nvidia, líder de mercado em hardware de IA.

Com a adição de Stuart Pann, ex-executivo da HP e Intel, como Chief Executive Officer (COO – Diretor de Operações), e Yann LeCun, cientista-chefe de IA da Meta, como consultor técnico, a Groq está fortalecendo sua liderança e capacidade de inovação.

Os chips LPUs da Groq são projetados para acelerar cargas de trabalho de IA, especialmente em processamento de linguagem natural, e prometem um desempenho até dez vezes mais rápido que os processadores tradicionais, consumindo apenas um décimo da energia.

Este desempenho superior é crucial à medida que as aplicações de IA se movem do treinamento (machine learning) para a inferência, exigindo uma estratégia que atenda à necessidade de velocidade e eficiência dos usuários e do mercado.

Diferenças Técnicas entre LPUs (Groq) e GPUs (Nvidia)

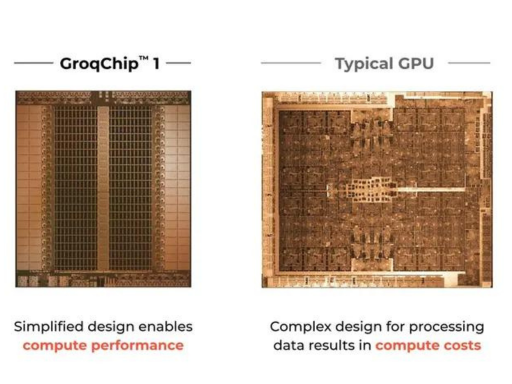

A principal diferença entre LPUs (Language Processing Units) da Groq e GPUs (Graphics Processing Units) da Nvidia está na arquitetura e design.

As LPUs da Groq foram desenvolvidas especificamente para acelerar tarefas de inferência de IA, enquanto as GPUs da Nvidia, originalmente projetadas para renderização gráfica, foram adaptadas para computação paralela em larga escala.

LPUs (Groq): Arquitetura e funcionamento

Cada LPU é uma unidade de processamento independente que pode executar modelos generativos de IA com alta velocidade e eficiência energética.

A arquitetura da Groq é verticalmente integrada, permitindo uma melhor coordenação entre hardware e software, o que resulta em um desempenho superior em cargas de trabalho de inferência.

Elas utilizam uma abordagem de processamento em fluxo contínuo (streaming) que permite a execução de inferências com baixa latência e alta taxa de transferência.

Isso as torna ideais para aplicações de IA que requerem respostas rápidas e em tempo real, como assistentes virtuais e sistemas de recomendação.

A Groq afirma que suas LPUs podem operar com dez vezes a velocidade e um décimo do consumo de energia em comparação com GPUs tradicionais, tornando-as ideais para operações em larga escala onde a eficiência energética é crucial.

GPUs (Nvidia): Arquitetura e funcionamento

As GPUs possuem milhares de núcleos de processamento que operam em paralelo, tornando-as ideais para tarefas que podem ser divididas em muitas operações simultâneas.

A arquitetura Compute Unified Device Architecture (CUDA) da Nvidia é amplamente utilizada em computação científica e aplicações de IA.

GPUs são muito flexíveis e podem ser usadas tanto para treinamento quanto para inferência de modelos de IA, mas tendem a ser menos eficientes em termos de consumo de energia em comparação com soluções especializadas como as LPUs.

As GPUs funcionam através da execução de muitas operações em paralelo, o que é extremamente eficiente para o treinamento de modelos de IA que envolvem grandes volumes de dados.

No entanto, essa abordagem pode resultar em maior latência durante a inferência.

Resumo do Raciocínio sobre Diferenças Técnicas

As LPUs da Groq e as GPUs da Nvidia são ferramentas poderosas para tarefas de IA, cada uma com seus pontos fortes.

As LPUs são projetadas especificamente para eficiência e velocidade em inferências de IA, oferecendo uma solução energeticamente eficiente e de baixa latência.

Por outro lado, as GPUs da Nvidia são extremamente versáteis e ideais para treinamento de modelos e tarefas computacionais paralelas, mas podem ser menos eficientes para inferência de IA em larga escala.

A escolha entre as duas dependerá das necessidades específicas do uso e das prioridades de desempenho e eficiência energética.

Um Pouco sobre a História da Groq

A Groq foi fundada em 2016 por um grupo de ex-engenheiros do Google, liderados por Jonathan Ross.

Ross é uma figura notável no campo da inteligência artificial, tendo anteriormente trabalhado no Google, onde liderou a criação do Tensor Processing Unit (TPU), um ASIC (circuito integrado de aplicação específica) acelerador de IA.

Este projeto, iniciado como um trabalho paralelo no Google, eventualmente evoluiu para se tornar um componente central da infraestrutura de IA da empresa.

Douglas Wightman, outro cofundador, também trouxe uma vasta experiência de seu tempo no Google X Lab (agora conhecido como X Development), onde trabalhou em projetos inovadores e de alta tecnologia.

A equipe fundadora da Groq se uniu com o objetivo de desenvolver uma nova geração de chips de inferência de IA que pudessem oferecer desempenho excepcional e eficiência energética superior às soluções existentes no mercado.

A trajetória da Groq exemplifica a combinação de inovação técnica e visão estratégica, posicionando-a como uma força emergente e disruptiva na indústria de inteligência artificial.

Conclusões

A recente rodada de financiamento de $640 milhões de dólares coloca a Groq em uma posição estratégica para desafiar a dominância da Nvidia no mercado de hardware de IA.

Com planos de expansão robustos, uma plataforma inovadora e uma equipe de liderança fortalecida, a Groq está bem equipada para transformar o cenário da inferência de IA.

À medida que mais desenvolvedores e empresas adotam suas tecnologias, a Groq se destaca como um player fundamental na democratização do acesso à IA avançada.

Cadastre-se para receber as últimas notícias sobre tecnologia e inteligência artificial e não perca nenhuma atualização importante!